Mancher hat sich in der Debatte um plagiierende Politiker gefragt, ob Professoren das nicht erkennen müssten. Oder wenigstens Computer, Allheilmittel der Moderne. Ganz so einfach ist es leider nicht.

Der Sturm der Entrüstung, der unseren ehemaligen Verteidigungsminister ausser Amt fegte, hat sich einigermaßen gelegt, auch wenn immer noch die letzten Ausläufer wie kleine Wellen durch die Medien rollen. Den ein oder anderen Politikerkollegen wird dies vermutlich noch um Job und Ansehen bringen, derweil die Universitäten ratlos sind, wie mit dem Problem des Plagiierens in Zukunft umgegangen werden soll.

Mancher Vorwurf wurde den Professoren und Universitäten gemacht: solchen Betrug, solche Schlampigkeiten müsse man doch wohl erkennen können? Ganz so einfach, habe ich mir sagen lassen, ist das aber gar nicht. Manchmal sind es grobe Fehler, die eher zufällig den Weg zur Originalquelle weisen. Andere erwischen Studenten bei der kreativen Textzusammenstellung, weil in den zunehmend üblichen englischen Hausarbeiten sprachliche Auffälligkeiten waren. Das wortwörtliche Kopieren jenseits der Muttersprache führt nämlich unweigerlich zu Brüchen in der sprachlichen Qualität, und die springen dem Korrektor tatsächlich ins Auge. Wenn Passagen von hervorragender Eloquenz auf dem Niveau eines Muttersprachlers abwechseln mit offensichtlicher Unkenntnis des korrekten Satzbaus, ist es nicht mehr schwer, den Betrüger zu entlarven. Verdächtige Passage kann man bei Gugel eingeben und erhält in aller Regel unter den ersten zehn Treffern die passende Originalquelle. Dabei allerdings ist einem der Anfangsverdacht gewissermaßen ins Gesicht gesprungen.

Anders bei Arbeiten auf Deutsch. Auch wenn die sprachliche Qualität sehr wechselhaft sein mag, ist das doch häufig viel weniger auffällig, weil die Diskrepanzen geringer sind. Man muß schon sehr genau lesen, mit gutem Augenmerk nicht nur auf den fachlichen Inhalt, sondern auch auf die Formulierungen und von vorneherein erhebliches Mißtrauen mitbringen, um solche Stellen auch auf Deutsch zu finden.

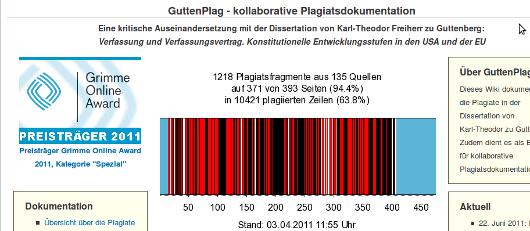

Quelle: https://de.guttenplag.wikia.com/wiki/GuttenPlag_Wiki

Hinzu kommt, daß gerade bei Doktorarbeiten die Länge zu gewissen Brüchen führt. Über drei Jahre und fünfhundert Seiten kann sich, je nach Stimmung, Thema, und Quellenlage, der Stil durchaus einmal ändern. Ein gut ausgelasteter Professor betreut neben Lehre, Forschung und öffentlichen Tätigkeiten gerne einmal sechs Doktoranden (oder mehr). Geht man davon aus, daß eine Promotion in den Gesellschaftswissenschaften (der bevorzugten Spielwiese von Politikern) im Schnitt zwei bis drei Jahre dauert, so muß der Professor pro Jahr zwei bis drei Dissertationen lesen, jede mindestens zweihundert Seiten lang – falls die Doktoranden sich kurz gefasst haben. Obendrein kennt er ja den Inhalt bereits in wesentlichen Zügen (hoffentlich!), das macht die Lektüre nicht eben spannender. Unter solchen Umständen sprachliche Brüche zu entdecken ist wahrhaftig keine ganz leichte Aufgabe. Nebenbei sollte man sich auch fragen, wieviel Mißtrauen ein Professor den eigenen Schützlingen entgegenbringen sollte bei der Lektüre?

Umso schöner, daß die Segnungen der Moderne auch hier behilflich sein können: große Teile der Detektivarbeit in den bisherigen Politikerfällen wurden von kollaborativen Wikis geleistet, wo die mühselige Aufgabe des Copy&Paste in Gugel, bzw. der Abgleich mit anderen Quellen, auf viele Köpfe verteilt wird. Nicht immer sind sich diese Köpfe in allem einig – aber das Konzept hat gut funktioniert. Im Rahmen der Skandale wurde auch viel über die Qualität von computerisierten Plagiats-Entdeckungs-Programmen diskutiert. Davon gibt es etliche auf dem Markt, was zu den schönsten Hoffnungen für die Zukunft der akademischen Qualität berechtigen würde – leider aber halten die Programme kaum, was sie versprechen. Woran das liegt, ist schwer zu sagen, denn die Erfinder und Hersteller sind mit konkreten Informationen eher geizig und nur ein Programm basiert auf offenen Quellcodes.

Sicher ist: Algorithmen vergleichen bei derlei Programmen Passagen aus dem zu prüfenden Zieltext mit anderen Texten. Dabei teilen sich jedoch schon die Geister. Viele Programme greifen auf eine eigens aufgebaute Datenbank zurück und verleiben jeden geprüften Text dieser Datenbank auch gleich ein (Datenschutz! Privatsphäre der Studenten!). In dem Fall können Übereinstimmungen natürlich nur gefunden werden, wenn die Originalquelle bereits gespeichert wurde – was bei den von Politikern gerne verwendeten Arbeiten des wissenschaftlichen Dienstes des Bundestags wohl eher nicht der Fall sein dürfte.

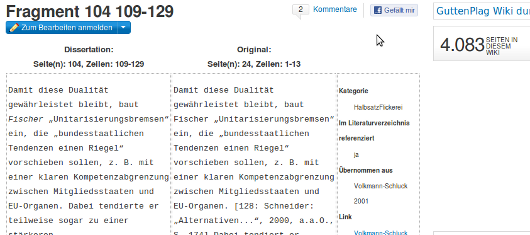

Quelle: https://de.guttenplag.wikia.com/wiki/Fragment_104_109-129

Davon abgesehen scheint es zwei Varianten von Suchalgorithmus zu geben. Beim Stringvergleich wird vorab die Länge von Wortfenstern (n-grams) definiert, danach sucht der Algorithmus nach Übereinstimmungen. Dabei wird es sich in der Regel um Wortkombinationen handeln. In dem Satz „Unsere Politiker schwindeln nicht, außer wenn sie promovieren” stecken acht Wörter. Definiert man daraus ein n-gram von drei Wörtern, kann das jede beliebige oder eine bestimmte Kombination aus den obigen acht sein. Die Wahrscheinlichkeit, daß jemand anderes unabhängig von mir drei davon verwendet hat, ist ziemlich groß. Für die Verwendung aller acht Wörter in beliebiger Reihenfolge finden sich hingegen nur noch 35.000 Treffer im Netz. Und die Wahrscheinlichkeit schließlich, daß jemand genau diesen Satz bereits formuliert hat – das n wäre dann acht in genau dieser Reihenfolge, oder eng beieinander stehend – ist ziemlich gering. Ähnliche Modelle verwendet Gugel übrigens auch für die Vervollständigung bzw. Kombination von Suchbegriffen. Hat man nämlich die Rechenmaschine ex ante mit genügend Texten gefüttert, kann man Wahrscheinlichkeitsverteilungen für die nächsten Wörter bzw. Buchstaben oder häufige Kombinationen ableiten.

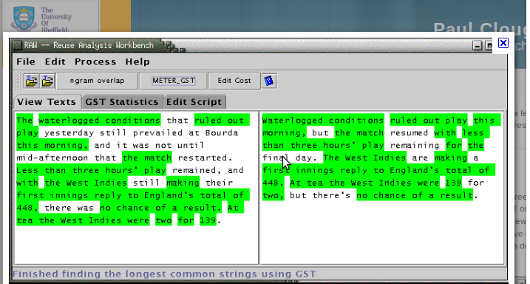

Ein anderer Algorithmus verwendet eine Methode namens „greedy string tiling“. Dabei identifiziert der Algorithmus Überlappungen zwischen Zieltext und möglichen Quellen. Diese können dann statistisch analysiert werden, nach Anzahl der Überlappungen, Länge der Überlappungen, deren Verteilung etc.

Beide Verfahren suchen dabei offensichtlich nach wortwörtlichen Übernahmen – der gut umformulierte Ideenklau hingegen oder auch übernommene Strukturen ohne eigene Denkleistung werden dabei nicht erkannt.

Quelle: https://ir.shef.ac.uk/cloughie/software.html

Das hingegen ist mit Autorenverifikation schon eher möglich. Dieses Konzept wurde ursprünglich dazu entwickelt, mittels linguistischer Profile die Urheberschaft zweifelhafter Dokumente festzustellen: also zum Beispiel, ob Shakespeare alle seine Sonette wirklich selbst geschrieben hat. Solche Algorithmen scheinen wesentlich komplexer zu sein, und es setzt voraus, daß man einen ganz sicher vom Autor stammenden Text als Grundlage hat. Dieser wird in seine Bestandteile zerlegt und deren gesamte Struktur analysiert, bis quasi ein sprachlicher Fingerabdruck des Autors definiert werden kann. Dieser berücksichtigt Wortwahl, Satzbau, Grammatik, Komplexität, überhaupt allerlei sprachliche Eigenheiten (ebenfalls, unter anderem, mittels n-grams) und kompiliert diese in einen Vektor. In einem zweiten Block des Algorithmus wird dann programmiert, wie der Vergleich des Fingerabdrucks mit dem Zieldokument vonstatten geht, also wie groß die Gemeinsamkeiten sein sollten (ebenfalls wieder unter Verwendung von Wahrscheinlichkeitsverteilungen). Daraus ergeben sich dann im zu untersuchenden Dokument Passagen, die ziemlich sicher vom Autor stammen – und solche, die es nicht tun. Diese kann man dann einer weiteren Analyse unterziehen.

Im Rahmen der Plagiatserkennung haben diese Algorithmen den Vorteil, daß sie keine digitale Datenbank von Referenztexten benötigen, sondern nur mit dem Zieldokument arbeiten – daher auch intrinische Plagiatserkennung genannt.

Ob irgendeine kommerzielle Plagiatserkennung solche Algorithmen verwendet, konnte ich nicht herausfinden – es hört sich leider so an, als sei Autorenverifikation zur Zeit eher ein Thema für Wissenschaftler und Computer-Nerds. Es scheint also, als müssten sich die Professoren in der näheren Zukunft weiterhin ohne Computerhilfe die Mühe machen, einen Anfangsverdacht zu etablieren.