Statistische Regularitäten finden sich in der Sprache, in der Musik, und natürlich in Zahlenwerken. Auch ohne zu verstehen, was diese Muster treibt, kann diese Erkenntnis sehr nützlich sein.

Forscher haben es nicht leicht mit dem Erkenntnisfortschritt. Selbst bei den sogenannten Naturgesetzen handelt es sich häufig nur um eine Beschreibung – warum die Dinge sind, wie sie sind, können auch Forscher oftmals nicht erklären.

Ganz besonders augenfällig ist dies bei den Potenzgesetzen („power laws“), die das Verhältnis zweier Variablen bei natürlichen Phänomenen mit polynomen Funktionen beschreiben, als zum Beispiel der Art y=a*x^b. Dabei ist das a nur eine Konstante – der entscheidende Bestandteil ist das „hoch b” (also zum Quadrat, oder hoch 3 etc.). Es ist geradezu frappierend, wieviele Zusammenhänge sich in dieser Art entwickeln, vor allem aber sind Potenzgsetze auch nützlich, um Größen- und Häufigkeitsverhältnisse untereinander zu beschreiben. Zum Beispiel stehen die Größe, der Rang und die Häufigkeit vieler Phänomene in einem umgekehrt proportionalen Verhältnis, besagt das (auf Potenzgesetzen aufbauende) Zipfsche Gesetz. Die Stärke und Häufigkeit von Erdbeben nach der Gutenberg-Richter-Skala (je stärker desto seltener) und die Bevölkerungszahl von Städten (wenige Megalopolen, viele kleine Dörfer) lassen sich zum Beispiel damit analysieren.

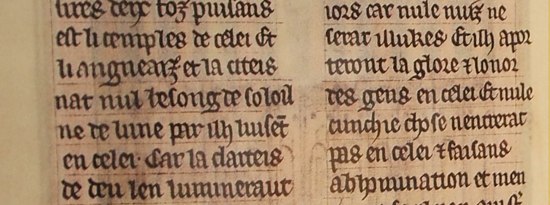

Das Zipfsche Gesetz gilt zwar für alle möglichen Zusammenhänge, hat aber seinen Ursprung in der Linguistik und wurde von dem Forscher George Kingsley Zipf Mitte des letzten Jahrhunderts mit Bezug zu Texten formuliert. Zipf stellte fest, daß in fast jeder Sprache bestimmte, vor allem kurze Wörter sehr häufig vorkommen , während andere, eher längere Wörter zunehmend seltener werden. Das häufigste Wort, im Englischen „of”, kommt fast doppelt so häufig vor wie das zweithäufigste Wort „to”. Interessant übrigens, daß diese Wörter in verschiedenen Sprachen ganz unterschiedlich sind – bei uns (in vielen Texten) der männliche Artikel „der”, im Englischen Präpositionen, bei den Franzosen erste eine Präposition, dann der weibliche Artikel „la” („le” folgt auf Platz 3). Mit nur 200 Wörtern hat man schon die Hälfte der am häufigsten verwendeten Wörter gelernt.

Faszinierenderweise scheint das Gesetz auch für Musik zu gelten. Ein argentinischer Forscher hat 4 Klavierwerke von Bach bis Schönberg durchkämmt, und die Häufigkeitsverteilung der Noten nach Tonhöhe und -länge aufgezeichnet. Die Noten von Hand zu zählen und aufzulisten wäre sicherlich mühsam gewesen, aber auch da helfen die Segnungen der Moderne, namentlich MIDI. Er stellt fest, daß in allen vier Werken die Statistik erstaunlich gut zu den Vorhersagen des Zipfschen Gesetzes passt. Der Vergleich ist nicht ganz einfach, weil eine hinreichend große Grundgesamtheit von Tonhöhen und -längen notwendig ist. Daher funktioniert es mit 26 Buchstaben nicht annähernd so gut wie mit Wörtern, die aus den unzähligen Kombinationen 26 Buchstaben gebildet werden können, und mit 7 Städten nicht so gut wie mit 700. Auch mit nur 12 Tönen wäre es nicht gegangen – wohl aber mit 12 Tönen in verschiedenen Längen, also vermutlich mindestens 12*5 Tönen, wenn man 16tel bis Ganze zählt.

Ich habe kurz überlegt, ob die musikalische Analyse wohl die Tonart berücksichtigt – man sollte ja meinen, daß das Varianten von C bei Werken in C-Dur sehr viel häufiger sind als andere Töne (das ist schließlich die Tonika). Die Tonalität bleibt allerdings unberücksichtigt und das Zipfsche Gesetz scheint für die Häufigkeit von Tönen in Notentexten ebenfalls erfüllt (allerdings am wenigstens in dem Werk von Schönberg – nicht verwunderlich, da Schönbergs Drei Klavierstücke bereits zu seinen atonalen Werken gehören, und damit wesentlich freier in der Verwendung von Tönen sind (ich vermute, bei Zwölftonmusik würde diese Art der Analyse keinen Sinn mehr machen).

Nun ist es zwar faszinierend, solche statistischen Muster im Alltag zu diagnostizieren – nur leider ist meistens völlig unklar, woher sie stammen. Im Hinblick auf die Sprache gibt es immerhin Erklärungsansätze. Zipf selbst glaubte, daß die an Kommunikation beteiligten Parteien den Arbeitseinsatz gering halten wollen, und sich daher in der Regel auf Kernwörter beschränken. Allerdings gilt der Zusammenhang sogar für Kommunikation, die nicht von Menschen geschaffen wird. Daß das Gesetz auch in der Musik gilt, wo Zweck und Nutzen viel weniger zielgerichtet sind, spricht ebenfalls gegen diese Begründung. Möglicherweise handelt es sich also einfach um eine jener vielen empirischen Regularitäten, die wir nicht erklären können.

Immerhin kann man Regularitäten – mit oder ohne tieferes Verständnis – nutzbringend einsetzen. Zum Beispiel sind die Worthäufigkeiten typisch für bestimmte, Texte, Reden und Autoren, sodaß quantitative Linguistik zur Zuordnung von Werken eingesetzt werden kann. So sind etwa viele delikate Texte des Rokoko aufgrund von Zensur und Verfolgung anonym erschienen; heute, da man sie für Meisterwerke der Aufklärung und nicht mehr für Scheiterhaufenmaterial hält, kann man damit endlich die Autoren würdigen. Ein Spezialfall des Zipfschen Gesetzes ist das Benfordsche Gesetz, welches sich mit der Häufigkeit von Zahlen befasst. Tatsächlich nämlich beginnen die meisten längeren Zahlenfolgen mit einer eins. Die zweithäufigste Anfangsziffer ist die zwei, die dritthäufigste die drei etc. Benford zeigte die Gültigkeit dieser Verteilung für diverse Zusammenhänge, zum Beispiel die Länge von Flüssen und die Bevölkerung amerikanischer Ortschaften.

Diese Eigenschaft läßt sich sehr nutzbringend für alle Arten von Zahlenwerken anwenden: wenn nämlich Menschen versuchen, Datensätze zu manipulieren, vergessen sie das Benfordsche Gesetz und verwenden die falschen Zahlen überproportional häufig. Forensische Statistiker machen sich dieses Phänomen schon länger zunutze, wenn sie Bilanzzahlen auf Wirtschaftskriminalität analysieren, und im Nachhinein wurde festgestellt, daß die Rahmendaten von Griechenland frappierend häufig vom Benfordschen Gesetz abweichen – ebenso wie die von Belgien und Österreiche, wenn auch in geringerem Umfang. Allerdings funktioniert das Gesetz nur, wenn die zugrundeliegenden Daten prinzipiell eine passende Häufigkeitsverteilung aufweisen (nämlich log-normal) – was zum Beispiel bei vielen natürlichen Wachstumsprozessen der Fall ist. Praktischerweise sind diese Gesetze “skaleninvariant” – es macht also keinen Unterschied, ob Flüsse in Meilen oder Metern oder Bilanzen in Dollar oder Euro angegeben werden.

Man kann sich natürlich auf den Standpunkt stellen, daß ein rein aus Beobachtung abgeleitetes Gesetz – zumal wenn es nur näherungsweise gilt, weil probabilistisch – eigentlich den Titel „Gesetz” gar nicht verdient. Anderereseits: Erkenntnis ist Erkenntnis, und in diesem Fall die Voraussetzung, um irgendwann vielleicht doch die ursächlichen Phänomene dahinter zu verstehen.